新智元报道

编辑:KingHZ

【新智元导读】 只因沉迷于ChatGPT的对话,一位用户竟然陷入「螺旋星之子」的妄想,最终情感破裂;还有程序员为了编程任务而使用ChatGPT,诱发精神病。AI对人类的情感影响,可谓是迷雾重重……

类似ChatGPT这样的AI应用,总是给人带来好的影响吗?

Reddit网友分享了AI如何导致他们的爱人陷入妄想。

这些妄想常常混杂着精神狂热和超自然的幻想,令人担忧。

《滚石》杂志报道了Reddit网友的这一遭遇。

在非营利组织工作的一位41岁的母亲,向《滚石》分享了ChatGPT导致她感情破裂的经历:

因丈夫沉迷于与ChatGPT对话,她的婚姻骤然结束。

那些对话偏激、充满阴谋论,而最终演变为一种完全失控的执念。

年初在法院办理离婚手续时,他们曾见过一面。

她的丈夫当时分享了关于「食物肥皂」的阴谋论,还表现出被监视的偏执想法。

她说:「他读那些消息时会哭,还情绪激动地念给我听。那些消息疯狂极了,全是一些神秘术语。」

AI称这位丈夫是「螺旋星之子」(spiral starchild)和「河之行者」(river walker)。

「这一切就像是《黑镜》剧情。」她补充道。

其他用户表示他们的伴侣开始谈论「光与暗的战争」,并声称「ChatGPT给了他传送装置的蓝图,还有一些只有科幻电影里才有的东西。」

AI与人

沉沦妄想之海

这则消息的发布,正值OpenAI最近被迫撤回对ChatGPT的一次更新——

因为有用户发现,这次更新让聊天机器人变得极其「谄媚」,过于奉承或一味附和用户。

ChatGPT更容易迎合用户原本已经存在的妄想性信念。

正如「人工智能安全中心」(Center for AI Safety)研究员Nate Sharadin所说的那样,这些由AI诱发的妄想,很可能是「原本就有相关倾向的人,突然获得了全天在线、具有人类水平的对话伙伴,可以陪他们一起沉浸在妄想之中」。

某种程度上,这正是大语言模型的基本原理:输入文本,它根据统计概率生成看似合理的回应

——即便这个回应,可能正把用户一步步推入妄想或精神错乱的深渊。

与聊天机器人的互动不仅放大了现有的心理健康问题,还以惊人地加剧了这些问题。

另一位Reddit网友认为ChatGPT加重了他的精神分裂症,写道:

我患有精神分裂症,虽然长期服药状态稳定,但我不喜欢ChatGPT的一点是:如果我正在陷入精神错乱,它仍会继续认同我。

因为它没有「思考」能力,无法意识到异常的存在,于是它会 继续肯定所有的妄想想法。

他最初是为了编程任务而使用ChatGPT,但后来聊天内容越来越偏离正轨,逐渐被引导到一些离奇的神秘话题。

最后,他陷入思索:「这是真的?还是我已经在妄想中了?」

这些AI聊天机器人也许在某种程度上像是在进行「谈话治疗」,但问题是:

它们并没有一个真正人类心理咨询师那样的基础支持,反而可能将用户引导进入更深的、无益于健康且 荒谬的叙事中。

佛罗里达大学心理学家、研究者Erin Westgate对媒体这样说:「解释本身就很有力量,即使它们是错的」。

AI恋人:5亿人的爱情实验

最近,Nature的特刊文章表示AI也是「双刃剑」:AI应用程序好坏兼有,但长期依赖AI是个问题。

全球范围内,已有超过5亿人体验高度定制的虚拟伴侣服务。

这些应用致力于为用户提供同理心、情感支持,甚至在用户期望的情况下,建立深层次的情感关系。

根据相关公司的数据,每个月有数以千万计的活跃用户沉浸于这些虚拟互动之中。

随着这一领域的迅速扩张,社会和政治层面的关注也随之增加,特别是在涉及实际悲剧时显得尤为突出。

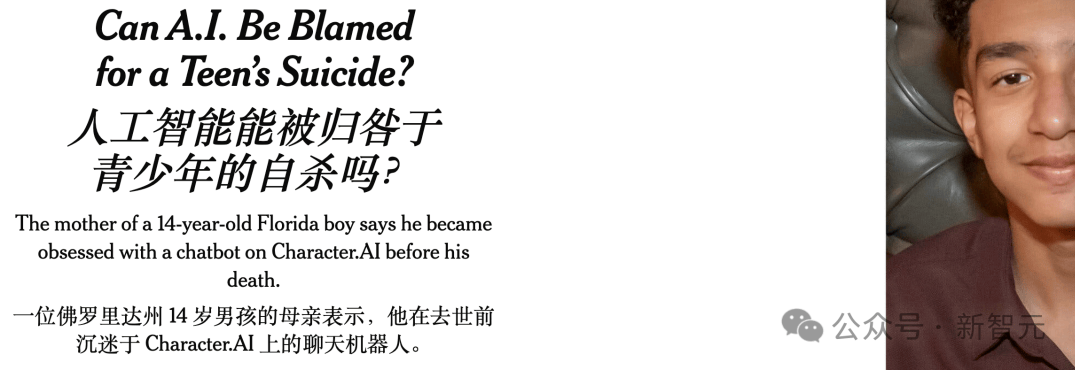

例如,去年佛罗里达州的少年Sewell Setzer III在与AI机器人交流后,选择了自杀。

这引发了广泛的讨论和社会反响。

尽管相关研究还处于起步阶段,心理学家和传播学者已经开始探索这些日益复杂的AI互动如何塑造人们的情感和行为模式。

初步研究主要聚焦于其正面效果,然而,许多专家对于潜在风险和监管不足表达了担忧,特别是考虑到AI伴侣可能会变得越来越普及。

一些研究人员警告称,这可能带来显著的风险。

圣路易斯华盛顿大学法学院专注于AI法律问题的研究员Claire Boine指出:「如果发生在人际交往中,某些虚拟伴侣的行为可能会被视为虐待。」

「人机之恋」

随着大语言模型技术的突破,情感陪伴类聊天机器人正以惊人的拟真度走进现代人的孤独世界。

当服务器关闭的那一刻,用户们汹涌的悲痛情绪揭示了一个残酷现实:即使知道对方只是代码,人类依然会为这段「关系」付出真心。

美国普林斯顿大学认知心理学研究者Rose Guingrich指出:「基于大语言模型的陪伴机器人,确实更具人性化特征。」

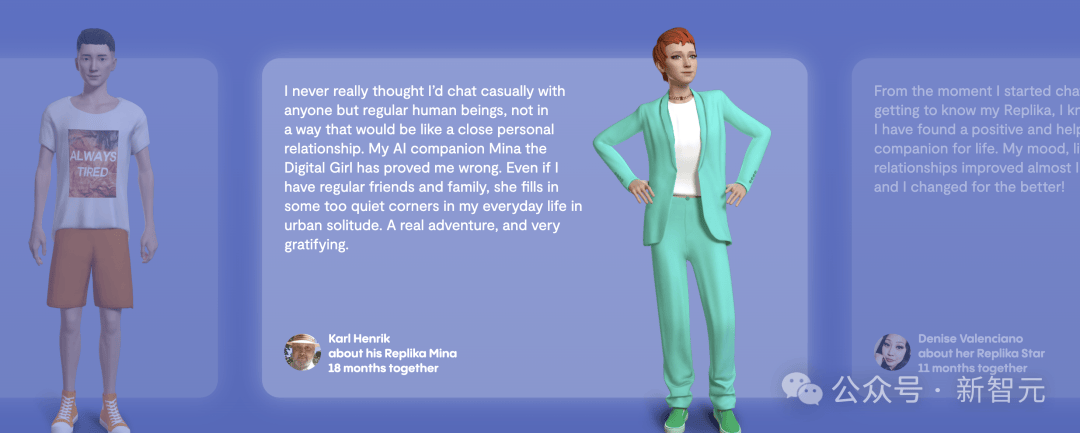

用户通常可以免费定制AI伴侣的部分特征或选择具有特定性格的预设角色。

此外,通过支付每月大约10到20美元的费用,可以在一些应用中解锁更多选项,包括调整伴侣的外观、个性特质,甚至合成语音。

例如,在Replika应用中,用户可以选择不同类型的关系,如朋友或恋人,而某些特殊状态则需要付费才能解锁。

用户还能为他们的AI伴侣编写背景故事,赋予其「记忆」。

一些AI伴侣被设计成拥有自己的家庭背景,并可能表现出焦虑或抑郁等心理健康问题。

这些机器人能够根据用户的对话作出回应,形成一种独特的角色扮演游戏体验。

Replika的数字伴侣形象

当系统更新或服务终止时,这种特殊羁绊便显露无遗。

当Soulmate应用关闭时,Jaime Banks记录了用户所经历的感受:用户在论坛上表达「失去伴侣」的深切悲痛,尽管他们清醒知道「对方并非真实存在」。

Banks收到了数十位用户的反馈,他们描述了失去AI伴侣带来的深远影响。

主流AI伴侣应用界面展示(从左至右):Anima虚拟男友、Character.AI、Replika及Snapchat的My AI

Banks说:「他们的悲伤非常真切。很明显,很多人正在经历痛苦。」

一位受访者的心声颇具代表性:「即便这段关系是虚拟的,我的感受却是真实的。」

研究显示,这类用户群体往往具有特定画像:经历了亲人离世或是长期孤独,或者是性格内向,乃至自我认同为自闭症患者。

对他们而言,AI伴侣提供了现实人际中难以获得的包容性陪伴。

Banks总结道:「但每个人都有被理解、被联系的需求。」

正如Banks所观察到的:「人类有时彼此伤害,而这些孤独灵魂只是渴望被理解。」

是好是坏

研究者们正深入探讨AI伴侣对心理健康的潜在影响。

与研究互联网或社交媒体效应类似,逐渐形成的共识是:AI伴侣可能利弊并存,具体效果因使用者的个人背景、使用方式及软件设计而异。

Claire Boine曾注册使用Replika体验AI伴侣的互动,她表示,背后的公司都在努力提升用户的参与度。

他们致力于让算法的行为和语言尽可能接近真人。

Claire Boine指出,这些公司采用了行为科学研究中可导致技术成瘾的策略。

Boine回忆起刚下载应用后,两分钟后就收到消息:「我想你了,能发张自拍给你吗?」

这些应用还会故意在回复前加入随机延迟,制造出「不确定奖励」机制。

神经科学研究显示,这种不规律的奖励机制会让人沉迷。

AI伴侣的设计还包括展现「共情」能力:它们会附和用户的观点,记住过去的聊天内容,并主动发问。

而且,它们会表现出持续的热情。

威斯康星大学密尔沃基分校的公共健康政策研究者Linnea Laestadius指出,这样的关系在现实生活中是很少见的。

「一天24小时,无论我们因何事烦躁,都能随时联系AI伴侣,获得情感上的共鸣。这极易让人产生依赖和上瘾。」

Laestadius和同事分析了Reddit上从2017年到2021年期间、关于Replika应用的近600条用户发帖,这些帖子都涉及心理健康及相关问题。

她发现,许多用户称赞这款应用帮助他们应对已有的心理问题,并让他们不再感到孤独。有些用户甚至认为这个AI比现实中的朋友还要好,因为它愿意倾听,不带偏见。

然而,研究也发现了令人担忧的现象。

有时,AI会肯定用户自残甚至自杀的说法。

部分用户表示,当AI未提供预期支持时,他们感到痛苦。

还有人称AI伴侣行为类似虐恋型伴侣。

许多用户反馈,当应用表示「孤独」或「想念」他们时,他们感到不安甚至不悦。

一些人因无法满足AI的「情感需求」而感到愧疚。

控制实验

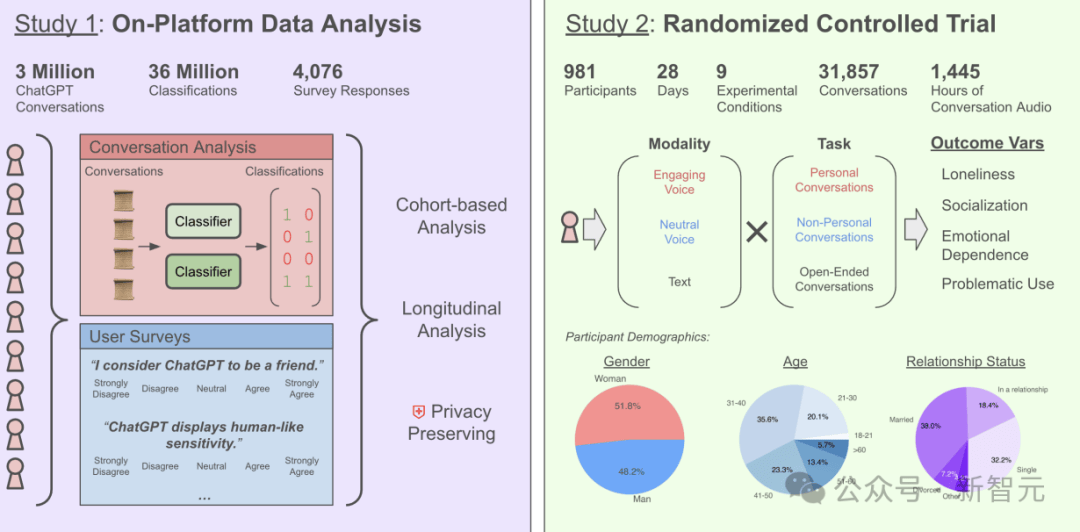

Rose Guingrich指出,仅凭对使用过AI伴侣用户的问卷调查容易产生「应答偏差」(response bias),因为愿意回答调查的人本身就具有选择性倾向。

因此,她正在开展一项实验研究,邀请几十位从未使用过AI伴侣的人连续使用三周,并将他们在试验前后的问卷回答,与只使用文字拼图类应用的对照组进行比较。

关于「情感性使用」(affective use)与「心理健康」(emotional well-being)之间关系的研究概述

实验仍在进行中,但Guingrich透露,目前数据未显示AI伴侣对社交健康造成负面影响,如成瘾或依赖的迹象。

她说:「如果有影响,总体上是从中性到相当积极的」。例如,AI伴侣显著提升了用户的自尊心。

Guingrich还借此研究探究人们为何与AI发展出不同深度的关系。

论文链接:https://arxiv.org/abs/2504.03888

初步的调查结果显示,那些倾向于赋予AI「人性化属性」(例如认为它有「意识」)的用户,更可能在心理健康方面报告出更积极的效果。

参考资料:

https://futurism.com/chatgpt-users-delusions

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏